NVIDIA представила новую вариацию ускорителей Hopper, предназначенную исключительно для больших языковых моделей (LLM), таких как ChatGPT. Технически, H100 NVL это не что иное как два H100, объединённых интерфейсом NVLink Gen4. При этом он обладает 188 ГБ памяти HBM3 по сравнению с 80 ГБ у предшественников и улучшенной производительностью.

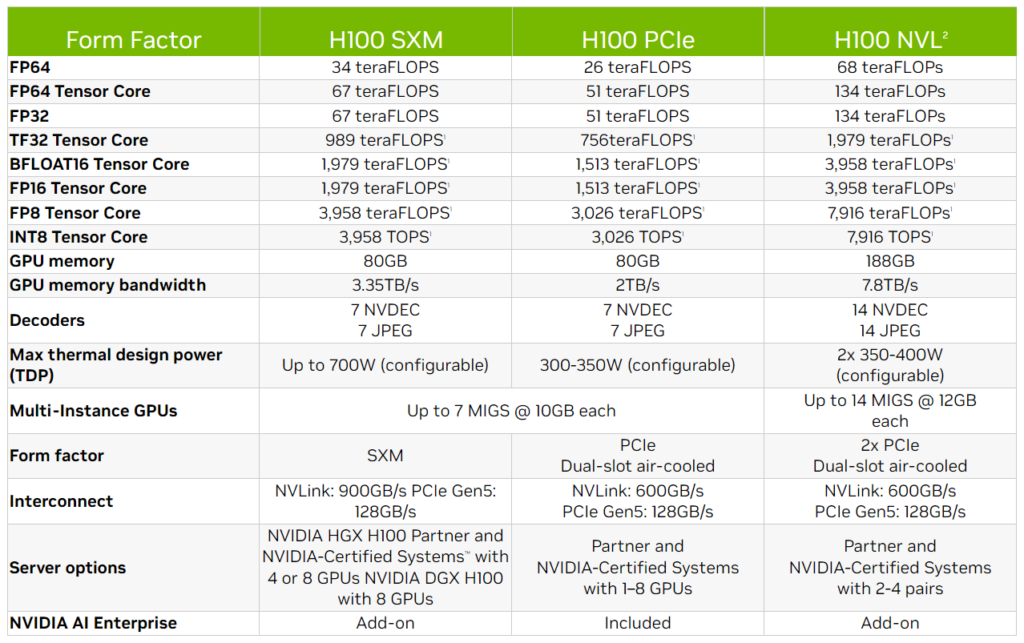

Максимальная пропускная способность модели составляет 7,8 Гб/с, то есть в два раза больше, чем у H100 SXM. Также ускоритель может похвастаться производительностью 68 TFLOPS (FP64), 134 TFLOPS (Tensor Core FP64) и 7916 TOPS (IN8), как показано на сравнительной таблице выше. NVIDIA заверяет, что H100 NVL обладает в 12 раз лучшей производительностью при работе с GPT-3, чем у предыдущего поколения A100.

NVIDIA не даёт иных подробностей об H100 NVL. Компания планирует выпустить его во второй половине 2023 года.